Na newsletter da semana passada, intitulada A Economia do ChatGPT, tivemos a oportunidade de tratar sobre o ChatGPT, uma das ferramentas de Inteligência Artificial mais comentadas dos últimos tempos. Apesar de termos discutido sobre o que ela é, e o que representa, deixamos de explorar com mais profundidade o que, de fato, tem proporcionado seu exuberante sucesso.

Nesta oportunidade desejamos argumentar brevemente que o sucesso recente de iniciativas de AI se deve à existência de um complexo ecossistema de novas tecnologias de software e de hardware, bem como de novas formas de organização da atividade econômica e de novos modelos de negócios. Este ecossistema tem proporcionado o surgimento da IA como uma GPT-General Purpose Technology (Tecnologia de Propósito Geral), gerando novas plataformas e aplicações que estão transformando nossa economia e sociedade.

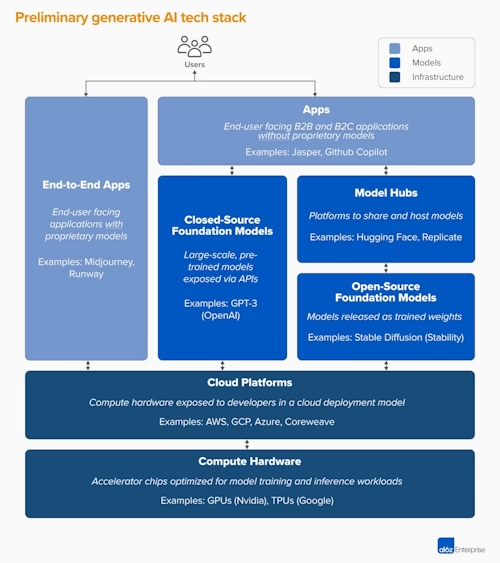

Nosso argumento toma como base (e reforça) aquele apresentado por Matt Bornstein, Guido Appenzeller e Martin Casado em um texto intitulado “Who Owns the Generative AI Platform”. Neste texto os autores apontam para um stack do mercado de IA (Figura 1 à frente). O stack é divido em três camadas: a) uma camada de Aplicações que integra modelos de IA em um user-facing product, tanto rodando seus próprios model pipelines (“end-to-end apps”) quanto dependendo de uma API de terceiros; b) uma camada de Modelos que empodera produtos de IA, tornados disponíveis tanto como APIs proprietárias quanto open-source checkpoints (os quais, por seu turno, requerem uma solução hospedeira); e uma camada de vendedores de Infraestrutura (i.e., plataformas de cloud e fabricantes de hardware) que rodam cargas de treinamento e inferência para modelos de IA generativa.

De forma resumida, gostaríamos de focar em alguns dos principais desenvolvimentos tecnológicos na camada de infraestrutura, e de modo particular para aquela que lida com hardware computacional. Sendo assim, deixaremos para tratar da camada de plataformas de cloud em outra oportunidade. A camada de aplicações foi, de alguma forma, discutida em nossa newsletter da semana passada, quando apontamos para o ChatGPT.

O novo paradigma de hardware vem sendo conformado pelos desenvolvimentos nos neural network accelerator chips (chips aceleradores de redes neurais), também conhecidos como AI accelerators (aceleradores de IA), que são hardware especializado projetado para acelerar computações de machine learning. Eles são frequentemente projetos de múltiplos processadores paralelos focando em aritmética de baixa precisão, arquiteturas de novos fluxos de dados, ou capacidade de computação in-memory (1).

Os massively multicore scalar processors, também conhecidos como superscalar processors, são um tipo de AI accelerator que usa um grande número de simple processing cores para executar diferentes tipos de algoritmos. O scalar processing está no coração deste acelerador de hardware. Uma das vantagens destes componentes de hardware é que eles usam unidades aritméticas simples que podem ser combinadas de vários modos para executar diferentes algoritmos (1).

Outra vantagem dos massively multicore scalar processors é que eles são altamente escaláveis. Diferentes tipos de processadores são úteis para diferentes tipos de modelos de machine learning. TPUs (Tensor Processing Units) por exemplo, são bem úteis para Convolutional Neural Network – CNN, enquanto GPUs (Graphic Processing Units) têm benefícios para algumas fully-connected Neural Networks, e CPUs (Central Processing Units) podem ter vantagens para Recurrent Neural Network – RNNs (1).

Por trás desses desenvolvimentos em hardware estão massivos investimentos de grandes empresas de tecnologia como Google (que desenvolveu a TPU, um acelerador de IA que é um application-specific integrated circuit – ASIC para trabalhos com redes neurais de machine learning), e Nvidia, que desenvolveu a GPU. A GPU é um circuito integrado especializado projetado para manipular e alterar memória para acelerar a criação de imagens em um frame buffer voltado para outputs (produtos) em um dispositivo para mostrar imagens.

O sucesso recente da Nvidia, em termos de faturamento e capitalização, é um indicativo de como esta indústria de IA tem um grande potencial de crescimento à frente, e de como este ecossistema crescerá ainda mais no futuro!

Se sua empresa, organização ou instituição deseja saber mais sobre o ecossistema de IA, não hesite em nos contatar!

Figura 1 – Stack tecnológico preliminar da IA generativa

Fonte: https://a16z.com/who-owns-the-generative-ai-platform/